本記事では、EVO-X2(128GB モデル) を使って LM Studio をインストールし、gpt-oss-120b をダウンロード・実行、さらに API サーバーモード で起動して Visual Studio Code の拡張機能「Codex」 から接続するまでの手順を、実際に構築する流れに沿って解説します。

「クラウドに依存せず、ローカル最強クラスの LLM を VS Code から使いたい」という方に向けた構成です。

注:記載内容の正確性には十分注意を払っていますが内容や動作を保証するものではありません。

前提環境

- マシン:EVO-X2(128GB メモリ:VRAM96GB設定)

- OS:Windows 11

- llm実行環境:LMStudio

- ローカルllm:gpt-oss-120b

- エディタ:Visual Studio Code + 拡張機能codex

注意: gpt-oss-120b は本体80GBのVRAMを必要とする大きなモデルですので、ユニファイドメモリ128GB搭載のPCが事実上の前提となります。

1.LM Studio のインストール

- LM Studio の公式サイトにアクセス

https://lmstudio.ai/ - 使用している OS 向けのインストーラ(exe)をダウンロード

- インストーラを実行し、指示に従ってインストールを進める

- 画面を進めると、「Choose your level」というレベルの選択肢が表示されます。レベル(User → Power User → Developer)に応じてLM Studioの設定項目が増えます。

後から変更可能なので今回は「Developer」を選択します。 - 以下の方法で日本語設定にする。

LM Studio 左側メニューの虫眼鏡アイコン[探索]タブをクリック →

[Setting]をクリック → 言語の設定から「日本語(Beta)」を選択

2.gpt-oss-120b のダウンロード

- LM Studio 左側メニューの虫眼鏡アイコン[探索]タブをクリック

- 検索欄に gpt-oss-120b と入力

- 表示されたモデル一覧から 「OpenAI’s gpt-oss 120B」 を選択

- Download をクリック

ダウンロード完了までしばらく待ちます(モデルサイズが大きいため)。

3.モデルのロードと動作確認

- [チャット]タブを開く

- 画面上部の[モデルを選択して下さい]欄をクリックして 「gpt-oss-120b」を選択

- 簡単なプロンプトを入力して応答が返ってくることを確認

モデルのロードが失敗する場合は以下の設定を見直してください。

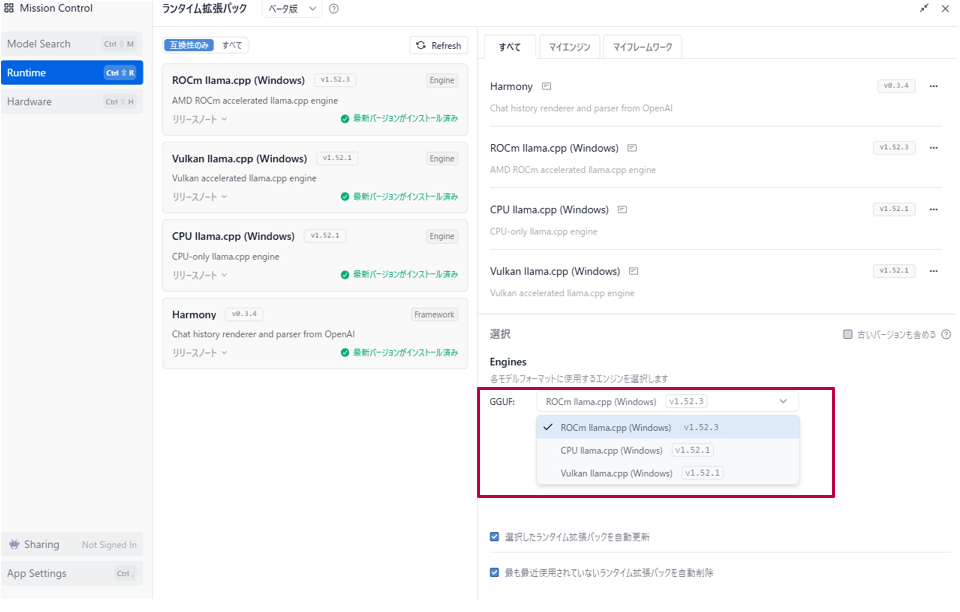

・[Engines]の設定を 「ROCm.llama.cpp(Windoes)」にする。

EVO-X2はAMDのGPUですのでこの設定が有効になります。

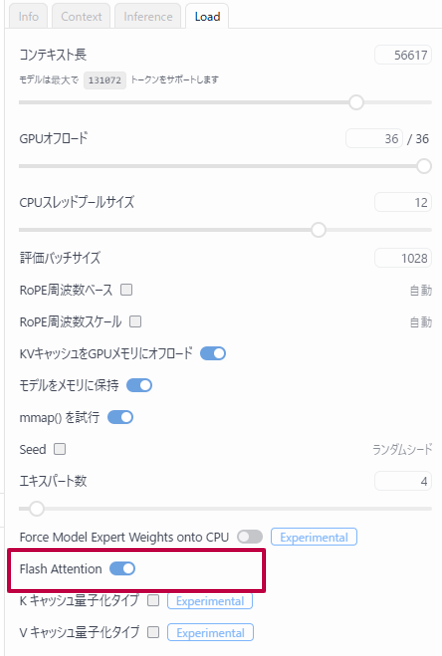

またトークン上限数はデフォルトで「4096」に設定されていますが、上限を設定で上げた場合にモデルのロードに失敗することがあります。その場合は [マイモデル]タブからモデルの設定画面を開き[Flash Attention]の設定をONにしてみてください。

4.API サーバーモードで起動する

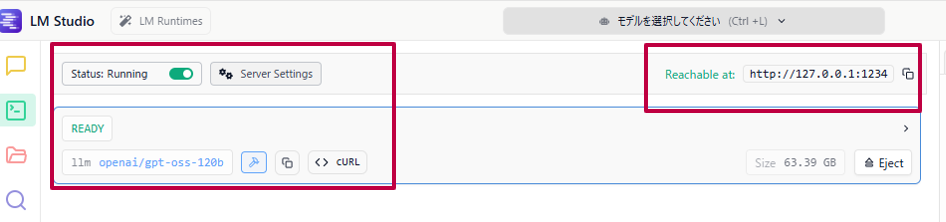

VSCodeなど外部ツールから利用するため、LM StudioをAPIサーバーモードで起動します。

- [開発者]タブをクリックする

- gpt-oss-120bのモデルが「READY」の状態であることを確認する

- Status設定を有効にして 「Running」の状態にする。

- Reachable at のURLをメモしておく。

5.VSCodeにCodex拡張機能をインストール&動作設定

- VSCodeの拡張機能の検索欄に codex と入力してCodexの正規版をインストールする。

- config.tomlを作成する。

Codexは設定ファイルであるconfig.tomlを読みに行きます。

以下の場所に(.codexフォルダが無い場合は作成してください)config.toml を作成します。

「 C:\Users\<ユーザー名>\.codex\config.toml 」 - config.tomlに記載した内容は以下になります。ご参考まで。

profile = local-llm

model = openai/gpt-oss-120b

[model_providers.lmstudio]

name = lmstudio

base_url = http://127.0.0.1:1234/v1

[profiles.local-llm]

model = openai/gpt-oss-120b

model_provider = lmstudio

[tools]

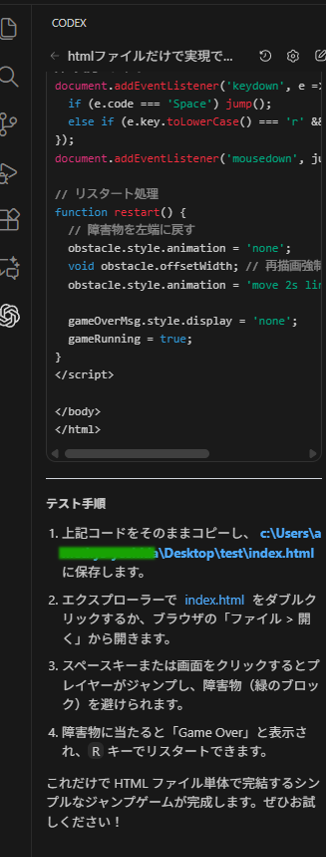

web_search = FALSE4.codex拡張機能の動作確認

codex拡張機能にプロンプトを入力して動作するかを確認します。

問題が無ければ無事にgpt-oss-120bに問合せすることが出来ます。

まとめ

EVO-X2(128GB)を用いれば gpt-oss-120b を現実的にローカル運用でき、さらに LM Studio の API サーバーモードによって OpenAI 互換 API を容易に構築し、VS Code と Codex を組み合わせることで強力なローカル AI コーディング環境が完成するため、クラウドにコードを送らずに開発を完結したい方にとって非常に魅力的な構成となります。